こんにちは。

前回はピアノの音声収録におけるマイキング(マイクのセッティング)、前々回では録音レベルについて具体的なお話をしました。

これまでのお話で、ピアノの演奏の音声をマイクで取り込む設定のところまでのイメージがつかめたかと思います。

マイクで取り込んだ音声は、レコーダー等の機器に取り込まれるとデータとして保存されますが、「保存する形式(フォーマット)をどうするか」という設定についても機器側で多種多様な設定が選択できます。

保存された演奏データは、何らかの機器で再生する事によって聴くことができるようになりますが、保存する形式が適切であれば、より良い音質で聴くことができるようになります。

今回は「音質」についてのお話を掘り下げていきます。

目次

「音質」って何?

そもそも「音質」って何でしょうか?

「音質が良い」「音質が悪い」といったように良し悪しで判断されますが、どういったものが「音質が良い」と言われるのでしょうか?

一般的にはCDの音質(16bit/44.1kHz)を超える音声はハイレゾと言われ、高音質だとされています。

しかしながら、こういった基準はアナログの音声をデジタルデータとして保存する際に、規格として都合がいいように単純に線引きしているようなものです。

本来「音質」というものは、人間が耳で聞いた時にクリアで聴き取りやすければ良い音質、あまりよく聴き取れない状態であれば悪い音質といったように、聴く人の主観的な感覚で判断されるものです。

当然、音楽を聴く場合と、会話を聴く場合では、人間が判断する「高音質」の基準も変わってくると思います。

では、ピアノ演奏の録音における「音質が良い」条件というのはどういったものでしょうか。

音楽のジャンルにもよりますが、クラシックの場合は「まるで目の前でピアノを弾いているかのように、演奏がそのまま伝わってくる」ような録音がベストではないでしょうか。

しかしながら「生演奏」に勝るものはありません。録音した時点で音質は下がってしまいます。

そこで、できるだけ生演奏に近い感じで録音できるよう、機材の設定をする必要があります。

前提として、前回まででお話しした録音レベルとマイキングが適切でなければ、良い音質にはなりません。アナログの音がデジタルデータに変換される時点で、既に音割れしていたり、音が小さすぎたり、響きすぎていたり、雑音が多かったりしていたら演奏は聴きにくい状態で保存される事になります。

この前提をクリアしたうえで、できるだけ高音質を目指します。

とは言え、あまり高音質にこだわり過ぎても、ある一定レベルを超えると非常に高価な録音機材を揃える必要が出てきます。録音データのサイズも大きくなりますし、聴く人も非常に高価な再生環境を準備しないと無いと違いが分からないような、一部のオーディオマニア向けの領域になってしまいます。

聴く人がスマートフォンのスピーカーだけで聴くのであれば、音質へのこだわりはあまり必要ありませんが、一般的に手の届く範囲の、それなりに高音質とされるスピーカーやヘッドフォン・イヤホンで聴くことを想定し、どういった音質で録音するといいのかを説明していきます。

ステレオとモノラル

ヘッドフォンやイヤホンで聴いた場合、左耳側と右耳側からまったく同じ音が出るような音源をモノラル、違う音が出ている音源をステレオといいます。

モノラルの音源を聴いた場合、真ん中から音が出ている感覚がすると思います。一方でステレオの場合は、音の広がりや奥行きを感じられます。

生演奏を聴く場合、音を鳴らしているピアノが1台であっても、人間の耳は2つあり両方の耳ではそれぞれ違った音の聞こえ方をしています。その左右の音の差が臨場感に繋がります。

したがって、ピアノの録音はステレオで録音しましょう。

ステレオ録音する場合、マイクやレコーダーはステレオ録音できるものを選ぶ必要があります。

ボーカルマイクのような声を収音するようなマイクは、モノラルでしか録音できないものが多いので、マイク選びで間違えないようにしましょう。

一方で、楽器の録音ではホームシアター等を想定したサラウンド(5.1ch等)で収音する必要はありません。

サラウンドは、聴く人の周囲360度で、それぞれの方向により異なる音が鳴っているように聴こえるので、ステレオより臨場感が出ると思われる方もいるかもしれません。

しかし、聴く人の周りをぐるっと複数の演奏者が取り囲んで演奏を披露するといったような、通常の音楽鑑賞と全く異なる演出が必要でない限り、サラウンドで収音する必要はありません。

演奏は聴く人の前方から鳴っており、2つの耳で聴くだけですので、ステレオ録音が最適だと考えます。

サンプリング周波数とビット深度

音は空気中を振動して伝わります。振動は波形で表されます。

デジタルデータとして録音する場合、アナログの波形を細かく分解して、どのタイミングでどの位置(音量)だったかというデータを、具体的な数値で保存する事になります。

サンプリング周波数(サンプリングレート)とは、この波形を1秒間に何分割するかを表し、ビット深度は音の大きさを何段階に分けるか、という数値になっています。

CD音質の場合、サンプリング周波数は44.1kHz、ビット深度は16bitとなっています。

これは波形を1秒間を44,100分割し、そのうちの1回を16bit(2の16乗=65,536段階)のデータとして保存している形式になっています。

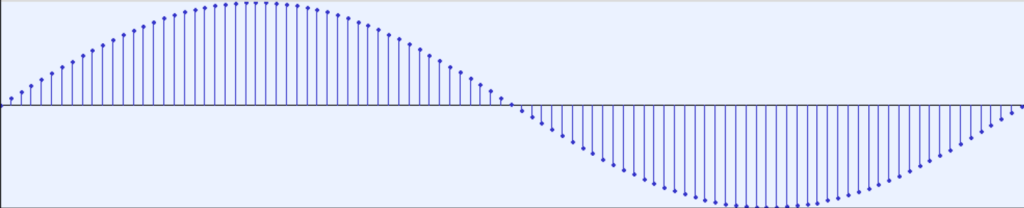

先ほどの波形を拡大するとこんな感じです。

この波形は調律等で使われる事のある440hzの音を、CD音質の波形で表し、拡大表示したものです。

波の1往復を表すのに、44,100÷440で約100個の点で表されます。

この100個の点が、16bit(65,536段階)のどの位置かというデータが記録されています。

サンプリング周波数が高くなるにつれて、横の間隔が細かくなり、より連続したデータになります。

44.1kHzに比べて88.2kHzは2倍の細かさになりますし、動画でよく使われる48kHzはCDの約1.09倍、96kHzは48kHzのさらに2倍といったように細かくなっていきます。録音データサイズも同じように増えていきます。

ビット深度は高くなるにつれて、波の高さ(音の大きさ)方向の細かさが増えます。16bitでは65,536段階ですが、ハイレゾ音源や高音質なブルーレイ等でよく使われる24bitは、2の24乗で16,777,216段階とったように、非常に細かくなります。

ビット深度が大きいと、小さい音から大きな音まで再現できるというところから「ダイナミックレンジが広い」というような言い方をします。

一般的なレコーダーの場合、何も設定を変えなければCD音質で録音する事になっていると思います。

上の波形は拡大すると隙間がかなり空いているように見えますが、人間の耳ではこれ以上細かくしてもなかなか違いが分からない程度にはなっています。

どのくらいのサンプリング周波数・ビット深度で録音すればいいのか

数値上は、サンプリング周波数もビット深度も大きくすればするほどアナログの波形に近づき、生の音に近いものになっていきます。

サンプリング周波数を高くすると高音域の再現性が高くなります。ピアノの場合は特に倍音に含まれる高周波数域の音の再現性に影響を及ぼします。

ビット深度を大きくすると、非常に小さな音から非常に大きな音までの、ダイナミックな音の抑揚の再現性が高くなります。

とは言え、CD音質の44.1kHz/16bitで人間の可聴域はほとんどカバーできています。それ以上の音質で録音した場合であっても、再生機器もそれなりの物を用意して聞き比べないと、ほとんど違いが分からない状態となります。

つまり、一般的にCD音質以上で録音できていれば通常聴く分には十分な音質となります。

その中でも、個人的な音質選択の目安は以下の通りです。

録音データを加工しない場合

まず、音の加工をせずに最終的にCDとして書き出す場合、44.1kHz/16bitで十分です。

そもそもCDが44.1kHz/16bitなので、それに合わせて録音しておけば書き出すときも同じ音質なのでトラブルも減ります。

次に、音の加工をせずに動画として残す場合は、48kHz/16bitまたは48kHz/24bitにしておきましょう。

動画の場合はサンプリング周波数48kHzが一般的なので、それに合わせておく方が良いです。

ビット深度は再生される環境を考慮して、あまりこだわらないのであれば16bitでいいですが、せっかくだから高音質で残したいという場合は24bitにしておきましょう。

録音データを加工する場合

次に、音の加工をする場合です。

基本的に音は加工すればするほど劣化していきますが、加工する時の柔軟性を考えると、ビット深度は16bitよりも24bitにしておいた方が良いと考えます。

例えば、16bitで録音すると縦方向に65,536段階しかないので、「音量を少し変えたい」といった時に階段の中間の値が取れず、微妙にずれた値になってしまう場合があります。

人間の耳では差を聞き取れないようなレベルの話ですが、こういう細かい編集を重ねていくと、積み重ねで大きな音質劣化に繋がってしまう場合があります。

最終的に書き出す音質はCD音質の16bitの場合でも、録音データを加工する場合は24bitで録音しておいた方が、音の加工に耐えられるという事になります。

サンプリングレートは、最終的に出力する形式に合わせて選択しましょう。

CDの場合は44.1kHzか88.2kHz、動画の場合は48kHzか96kHzが良いと考えます。(データ容量が許すならもっと上の192kHzでもいいかもしれませんが、人間の可聴域を完全に超えている為、一般的にはあまり意味は無いと言われています。)

最終出力の2倍の周波数であれば、録音データから書き出すデータに変換する際に、必要なタイミングのデータは全て揃っている事になります。例えば88.2kHzから44.1kHzに変換する場合、1秒間に88,200個のデータをちょうど半分の44,100個のデータに変換する事になりますから、2つの点をまとめて1つの点にするようなイメージになります。

逆に48kHzから44.1kHzに変換するような場合、1秒間に48,000個のデータから44,100個のデータに変換する事になりますので、タイミングが少しずつずれている事になります。特に高音域では波長が短くなるので、変換もきれいにできない可能性があります。

とは言え、通常の人間の耳ではそこまでの違いを聴き取ることは難しいので、神経質になる必要はありません。

最初にも言いましたが、一般的にCD音質以上で録音できていれば通常聴く分には十分な音質となっています。

音声フォーマットとビットレート

音声をデータとして保存する場合、WAVやAAC、MP3等だいたい数文字程度のアルファベット(拡張子)で表される形式のデータで保存する事になります。

普段パソコン等を利用しない方にとってはあまり馴染みのない物だと思います。

具体的には、上で説明した波形データを、どういう形でデータとして保存するかという種類になります。

また、ビットレートは各音声フォーマットごとに違いはありますが、96kbps、128kbps、160kbps、192kbps・・・といったようにkbpsの単位で表されます。

これは、音声データ1秒あたり、何ビットのデータサイズになるかという事を表しています。数値が大きいほど高音質になりますがファイルサイズが大きくなります。

音声フォーマットには大きく分けて以下の3種類のフォーマットがあります。

- 非圧縮音声フォーマット

- 非可逆圧縮音声フォーマット

- 可逆圧縮音声フォーマット

それぞれについて説明をしていきます。

非圧縮音声フォーマット

非圧縮音声フォーマットは「サンプリング周波数とビット深度」で説明したような波形データを、そのまま保存する形式です。

WAVやAIFFといった形式のファイルに、リニアPCMと言われる波形データを格納する事が多いです。

例えば44.1kHz/16bitのステレオで録音したデータは、1秒間に44,100回16bitのデータが、ステレオの左右で2つ保存されるため、44.1kHz×16bit×2=1411.2kbpsとなります。

データは圧縮されていないためデータサイズは大きいですが、音の劣化はありません。

CDは非圧縮音源になりますので、CDに書き出す場合は必然的にこのフォーマットで保存するのがベストになります。

また、音声データを編集する場合もこの形式にします。次に説明する圧縮音源では、データの圧縮の過程で音質が劣化してしまいますので、中間データとしても非圧縮形式として保存する事になります。

非可逆圧縮音声フォーマット

私たちが普段耳にしている音楽、例えばYouTube等で見ている動画の音声や、ダウンロード配信されている音楽等は非可逆圧縮音声フォーマットがほとんどです。

AACやMP3、WMA等の形式がそれにあたります。

これらは、元の音声(波形)から人間の可聴域の範囲外の音をカットしたり、大きい音の後ろに隠れて聞き取りにくい音を省き、効率よくデータを圧縮しています。

したがって、一度圧縮した音声からは、元の波形を完全に復元する事はできませんが、非圧縮音声データと比較すると、データサイズが数分の1という非常に小さいサイズになります。

録音時は、どれくらいのサイズに圧縮するかという指標として、ビットレートを指定する事ができます。

ビットレートを高く設定すると、圧縮前の音と聞き分けが難しいレベルの、自然な音声のまま、ファイルサイズをそこそこ小さくできます。

逆にビットレートを低く設定すると、非常にファイルサイズが小さくなりますが、耳で聞いても分かるほど音質が劣化します。

動画でよく使われているAACで言うと、だいたいステレオの192kbps以上のビットレートであれば、非圧縮の音源と比較してもあまり差は分からないレベルだと言われています。

それ以上のビットレート(256kbps、320kbps等)はあまり必要となる場面はありませんが、ビットレートの違いを聞き分ける事ができて、その違いが気になる場合であれば選択するのも有効です。

逆に128kbps以下になってくると、特に高音域のカットが顕著になってくるので、音がこもったり、伸びないような感じになってきます。特に音域の広いピアノ演奏の場合は、あまり下げすぎない方が良いと思います。

192kbpsの場合であっても、CD音質の非圧縮音源と比較すると、データサイズは192kbps÷1411.2kbps=1/7.35となり、非常にコンパクトなデータサイズで保存できます。

よく利用されるMP3とAACでは、AACの方が低ビットレートの場合は音質の劣化が少ないとされていますが、そもそも音質の劣化がほとんど分からないレベルを保つ事を目的としているので、目的に合ったフォーマットで、192kbps以上を目安に設定しましょう。

可逆圧縮音声フォーマット

非可逆圧縮音声フォーマットと異なり、元の波形を復元できる形で圧縮したフォーマットです。

FLAC等の形式がそれにあたります。

データサイズがあまり小さくならず、波形の圧縮・復元に少し時間がかかるため、録音時にこのフォーマットを選択する事はあまりありません。

音質の劣化無く圧縮できるので、高音質な音源として配布するような場合に利用する事があります。

動画撮影時の音声フォーマットについて

コンクール等の応募では、音声だけでなく動画で提出する事が多いと思います。

動画でも、音声はここまでで説明した音声フォーマットのどれかが使われることになりますが、撮影時に音声フォーマットを選択できない撮影機材も多いと思います。

もし、撮影機材の設定で音声の品質を選べるようでしたら、これまで説明してきた内容をもとに、できる限り高音質で収録できるような設定にしましょう。

リニアPCMで収録できる場合、非圧縮音声になりますので、サンプリング周波数とビット深度は48kHz/16bitまたは48kHz/24bitで設定しましょう。

非可逆圧縮音声の場合はAACの場合が多いです。この場合はビットレートのみが選択できるケースがほとんどだと思いますので、192kbps以上で設定しましょう。

設定ができない機材の場合、どんなフォーマットでどれくらいの音質で音声が収録できるのか、機材のマニュアル等を一度確認し、あまり音質が良くなさそうでしたら別の機材を検討してもいいかもしれません。

また、撮影時の動画の画質設定で、高画質の場合は音声も良い音質で収録し、低画質の場合は低めの音質で収録する機材もあったりしますので、確認しましょう。

(ピアノの演奏動画を撮影する時の気を付けるべき事は、別途記事で紹介する予定です。)

まとめ

ここまでの「ピアノの音声収録のお話」で、3回に分けて録音レベル、マイキング、音質についてお話してきました。

良い録音をするためには、適切な位置に設置したマイクから、適切な録音レベルで収音し、適切な音声フォーマットで収録する事が大切だという事になります。

どれか1つでも状態が悪くなってしまうと、たとえ他の条件が良かったとしても、最終的に残る録音データとしてはあまり良いものを残せません。

これらの点に注意し、良いピアノ演奏を録音していきましょう。

次回は、具体的に録音に利用する機材を紹介したいと思います。

それではまた!